Le controversie sul modo in cui i set di dati addestrano gli strumenti di Intelligenza Artificiale (IA) hanno reso l'opinione pubblica diffidente nei confronti dell'IA.

La percezione comune è che l'intelligenza artificiale raccolga tutte le informazioni che riesce a raccogliere online per addestrare i suoi algoritmi, ignorando la privacy delle persone e i requisiti delle leggi sulla protezione dei dati.

Gli scandali pubblici, come lo scraping illegale di Facebook da parte di Clearview AI, hanno messo le piattaforme di social media al centro delle preoccupazioni dell'opinione pubblica sull'IA e sulla privacy dei dati.

In questo articolo chiarisco come vengono addestrati gli strumenti di IA generativa e come i dati disponibili al pubblico possono essere utilizzati come parte del processo, rispettando alcuni requisiti legali e tecnici.

- Che cos'è l'iA?

- Come vengono addestrati i modelli di intelligenza artificiale?

- I diversi tipi di dati utilizzati per addestrare l'iA

- l'addestramento dell'intelligenza artificiale con i dati pubblici è consentito dalle leggi sulla privacy?

- Le piattaforme di social media possono usare i vostri dati per addestrare l'intelligenza artificiale?

- Riassunto

Che cos'è l'iA?

l'intelligenza artificiale o IA si riferisce a macchine in grado di svolgere funzioni simili a quelle umane.

Esistono diversi tipi di IA, ad esempio:

- L›intelligenza artificiale debole esegue una gamma ristretta di funzioni basate su modelli fissi che è stata programmata per rilevare.

- L›intelligenza artificiale forte esegue funzioni complesse trovando i propri schemi in un insieme di dati, quasi come se avesse una "mente" propria, e può continuare ad apprendere in modo indipendente.

Naturalmente, a differenza degli esseri umani, l'iA non ha una mente vera e propria come noi. Si basa invece sui tipi di dati che le vengono forniti.

Inoltre, a differenza degli esseri umani, l'intelligenza artificiale è in grado di individuare modelli in quantità gigantesche di informazioni in un modo che noi non siamo in grado di fare.

Utilizza questi schemi per completare la sua funzione primaria.

Ad esempio, quando si chiede a un'intelligenza artificiale che scrive per un blog di creare un contenuto, questa genera la sua risposta accedendo a un set di dati, che a volte contiene centinaia di gigabyte, se non terabyte, di testo proveniente da varie fonti.

Come vengono addestrati i modelli di intelligenza artificiale?

Per capire come vengono addestrati i modelli di IA, è importante notare che gli strumenti di IA recentemente diffusi si qualificano come IA generativa (GenAI), tra cui:

- ChatGPT-3 e 4 di OpenAI

- PaLM 2 e Bard di Google

- CoPilot di GitHub

GenAI è una branca dell'IA specializzata nella generazione di contenuti, sotto forma di testo, immagini, video o codice.

Utilizza algoritmi chiamati Large Language Models (LLM) che necessitano di grandi quantità di dati per l'apprendimento e l'addestramento.

l'addestramento di un LLM comprende una fase iniziale, detta anche di pre-addestramento, seguita da una messa a punto del modello su compiti specifici o aree di miglioramento. Entrambe le fasi richiedono grandi quantità di dati, con migliaia o decine di migliaia di esempi.

Vediamo cosa dicono alcuni leader del settore su come addestrano i loro strumenti GenAI.

ChatGPT

Cominciamo con ChatGPT, il LLM di OpenAI, che nelle sue FAQ elenca le tre categorie seguenti:

- Informazioni disponibili al pubblico

- Informazioni concesse in licenza da OpenAI da terze parti

- Informazioni fornite dagli utenti o dai formatori umani

Leggete lo screenshot qui sotto per saperne di più su come OpenAI sostiene di aver addestrato ChatGPT.

Tecnicamente, GPT-3 è stato addestrato su 45 terabyte di dati, mentre GPT-4, utilizzato da ChatGPT Plus, è stato stimato su un petabyte di dati.

Per dare un'idea della quantità di informazioni, un terabyte rappresenta 500 ore di video HD e un petabyte è pari a 1000 terabyte.

Bardo

Vediamo ora come è stato addestrato il chatbot AI di Google, Bard.

Le fonti elencate sono le seguenti:

- Conversazioni con il Bardo

- Informazioni sull'uso del prodotto

- Posizione dell'utente

- Feedback degli utenti

Per saperne di più, si può leggere la schermata qui sotto, tratta dall'informativa sulla privacy di Bard.

Vorrei sottolineare come Google faccia riferimento all'uso dei dati per addestrare il Bardo in modo coerente con la sua Informativa sulla privacy, che menziona quanto segue in merito alla raccolta di dati da fonti pubblicamente disponibili per l'addestramento dell'IA:

"Ad esempio, possiamo raccogliere informazioni pubblicamente disponibili online o da altre fonti pubbliche per contribuire all'addestramento dei modelli AI di Google e alla creazione di prodotti e funzionalità come Google Translate, Bard e le funzionalità Cloud AI. Oppure, se le informazioni della vostra azienda appaiono su un sito web, potremmo indicizzarle e visualizzarle sui servizi di Google".

CoPilota

Infine, leggiamo come GitHub utilizza i dati per addestrare il suo programmatore AI, CoPilot.

Per saperne di più, leggete la schermata qui sotto, tratta dalla pagina delle caratteristiche di CoPilot di GitHub.

Come OpenAI e Google, anche GitHub fa riferimento all'utilizzo di informazioni disponibili al pubblico come fonte per l'addestramento dell'IA.

I diversi tipi di dati utilizzati per addestrare l'iA

La GenAI ha bisogno di grandi quantità di dati e utilizza diverse fonti per addestrare questi algoritmi - prima come risorsa primaria per il suo sviluppo e poi per migliorare la sua precisione e sviluppare i suoi campi di applicazione.

Dai tre esempi appena citati, possiamo dedurre che le entità utilizzano tre categorie principali di dati per addestrare i modelli di intelligenza artificiale.

Dati disponibili al pubblico

La maggior parte delle GenAI utilizza dati disponibili pubblicamente per l'addestramento.

Per dati disponibili al pubblico si intendono tutte le informazioni accessibili al pubblico con determinate restrizioni sulle modalità di accesso, utilizzo e distribuzione.

Queste restrizioni spesso derivano dai diritti di proprietà o intellettuali sui dati detenuti dall'entità che li rende pubblici.

Ad esempio, i post pubblici di Facebook rientrano in questa definizione.

![]()

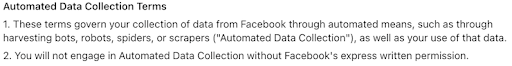

I post resi pubblici dall'utente sono accessibili ad altre parti, ma i termini di servizio di Facebook ne limitano l'utilizzabilità e la distribuzione.

In particolare, nel caso dell'addestramento di modelli di intelligenza artificiale, la raccolta automatica di questi post è limitata dai Termini di raccolta automatica dei dati, che impediscono a soggetti esterni di raccoglierli senza l'autorizzazione scritta di Facebook.

Pertanto, sebbene esistano alcune restrizioni, la sua disponibilità generale la rende una grande risorsa per l'addestramento di modelli di intelligenza artificiale.

Di conseguenza, è una fonte predominante per la fase di pre-addestramento dei modelli di IA e le fonti più comuni per queste informazioni includono:

- Archivi web: Siti come Common Crawl effettuano il crawling del web per estrarre i dati grezzi delle pagine, i metadati, i testi e altre risorse accessibili, archiviandoli. I dataset di pre-training di GPT-3 comprendevano il 60% del corpus di Common Crawl.

- I contenuti pubblici dei social media: Queste piattaforme rappresentano immensi bacini di dati, che forniscono informazioni su milioni di comportamenti e caratteristiche. Ogni piattaforma ha termini diversi che limitano i dati che entità esterne possono raccogliere, e utilizzano i dati pubblici per addestrare i propri modelli di intelligenza artificiale, come Meta e X/Twitter.

- Repository ad accesso aperto: Fonti come i repository pubblici di codice di Github contengono dati di ricerca provenienti da enti pubblici o privati e forniscono un accesso gratuito e permanente ai set di dati che possono essere utilizzati da chiunque.

- Le istituzioni pubbliche aprono banche dati: Siti come l'Archivio Nazionale degli Stati Uniti includono solitamente dati istituzionali su vari argomenti, come economia, storia, scienze, discipline umanistiche e altro.

Dati aperti e dati disponibili al pubblico

Quando si definiscono i dati pubblici, è importante menzionare anche i dati aperti.

Spesso utilizzati in modo intercambiabile, i dati aperti sono una sottocategoria di dati pubblici caratterizzata dall'assenza di restrizioni all'accesso, all'uso e alla distribuzione.

Alcune delle fonti più importanti di dati aperti sono i governi, che dispongono di portali di dati aperti per condividere i dati raccolti dalle istituzioni pubbliche.

I dati aperti sono solitamente soggetti a una licenza aperta, ben strutturati e leggibili dalla macchina.

Dati di utilizzo del prodotto

un'altra fonte di dati per l'addestramento dei modelli di intelligenza artificiale sono i dati di utilizzo dei prodotti, che gli utenti generano quando utilizzano un prodotto.

Poiché si presuppone che un prodotto sia già funzionante, questa fonte di dati viene utilizzata durante la fase di messa a punto dell'addestramento dell'IA per fornire informazioni sul comportamento e sulle preferenze degli utenti.

È possibile suddividere l'utilizzo dei prodotti in due categorie:

- Dati sul contenuto dell'utente: I dati contenuti nei contenuti generati dagli utenti quando interagiscono con il prodotto e possono includere testi, immagini, video, codici e in generale qualsiasi informazione che l'utente decide di condividere con il prodotto.

- Metadati: Dati generati in relazione ai dati dei contenuti dell'utente, come "dati sui dati", e di solito includono dettagli sui dati dei contenuti dell'utente, come l'ora di creazione, la fonte, le dimensioni, la posizione, le impostazioni del dispositivo e altro ancora.

Tuttavia, poiché questo tipo di dati è legato agli utenti, è considerato un'informazione personale.

Il modo in cui un prodotto raccoglie e utilizza questo tipo di dati è soggetto alle leggi sulla privacy e ai Termini di servizio delle aziende.

Dati sui prodotti in licenza

Come i dati sull'utilizzo dei prodotti, i Dati sui prodotti soggetti a licenza sono ottenuti da terzi a cui l'iA è stata concessa in licenza.

Attraverso una licenza, un'azienda può utilizzare modelli di IA sviluppati e addestrati da un'altra azienda per operare all'interno dei suoi prodotti.

Ad esempio, è così che Microsoft ha ottenuto la licenza per utilizzare la tecnologia Chat GPT-3 di OpenAI per il suo prodotto.

Tuttavia, è difficile sapere con esattezza in che misura i dati di utilizzo dei prodotti vengano raccolti da OpenAI per migliorare il suo modello di intelligenza artificiale.

La parola di un esperto

Alla domanda sulle implicazioni dell'IA sulla privacy dei dati per le aziende e i consumatori, Anupa Rongala, CEO di Invensis Technologies, ha dichiarato: "l'iA ha trasformato la privacy dei dati rendendo la sicurezza più intelligente, ma anche più vulnerabile".

Ha aggiunto: "Le aziende analizzano oggi vaste serie di dati in tempo reale, rilevando le minacce più rapidamente che mai. Allo stesso tempo, l'automazione guidata dall'AI aumenta i rischi, poiché gli algoritmi spesso raccolgono, elaborano e deducono informazioni sensibili senza un chiaro consenso dell'utente".

"Le aziende che abbracciano l'iA responsabile non solo rispetteranno le normative, ma creeranno anche una fiducia a lungo termine". Anupa Rongala, CEO, Invensis Technologies

Per lei, le sfide più grandi sono: "I pregiudizi, l'accesso non autorizzato ai dati e l'eccessiva dipendenza dal processo decisionale guidato dall'intelligenza artificiale".

"Trovare un equilibrio è possibile: una governance chiara, una supervisione umana e pratiche etiche di IA non sono negoziabili.

l'addestramento dell'intelligenza artificiale con i dati pubblici è consentito dalle leggi sulla privacy?

Tra tutte le fonti utilizzate per l'addestramento dei modelli di intelligenza artificiale, i dati disponibili pubblicamente costituiscono la risorsa principale, in primo luogo per la loro disponibilità, ma anche perché le restrizioni all'accesso, all'uso e alla distribuzione sono scarse o nulle.

Di conseguenza, dall'apparizione degli strumenti GenAI si è assistito a un aumento della portata e della frequenza della raccolta di dati disponibili al pubblico.

Da un punto di vista normativo, i dati disponibili al pubblico - nella misura in cui si qualificano come informazioni personali - sono meno regolamentati dalle leggi sulla privacy rispetto alle informazioni personali non pubbliche.

La dimensione "pubblica" suggerisce che a un certo punto l'individuo a cui appartiene l'ha resa pubblica, rinunciando alle aspettative di privacy.

In questa sezione mi concentrerò sulle leggi sulla privacy dell'Unione Europea e degli Stati Uniti, spiegando come esse definiscono i dati personali disponibili al pubblico e cosa richiedono per la raccolta legale.

Leggi sulla privacy nell'UE

Nell'UE, il GDPR non definisce i dati personali disponibili al pubblico, il che significa che non vi è alcuna differenziazione tra dati disponibili al pubblico e dati personali.

In applicazione, il GDPR si applica a qualsiasi dato personale, indipendentemente dalla sua fonte.

Di conseguenza, i requisiti di notifica per i responsabili del trattamento delineati dall'articolo 14 in merito alla raccolta di informazioni da fonti diverse dall'interessato stesso si applicano alla raccolta di dati pubblici ai sensi del GDPR.

In particolare, per il trattamento di tali dati personali sono necessarie una finalità e una base giuridica.

Cosa dice il GDPR sui dati pubblici

Sebbene il GDPR non definisca i dati pubblici, li menziona e richiede ai responsabili del trattamento di comunicare se i dati provengono da fonti disponibili al pubblico, nell'articolo 14.

Inoltre, l'articolo 9 stabilisce regole che si applicano a categorie speciali di dati personali e sembra limitare i requisiti quando si tratta di dati disponibili al pubblico.

Se il trattamento riguarda dati personali resi manifestamente pubblici dall'interessato, non è necessario un consenso esplicito o un'altra base giuridica come quella elencata nell'articolo 9 (principalmente leggi e regolamenti specifici o l'istituzione, l'esercizio o la difesa di rivendicazioni legali).

Quindi, quando si tratta di addestrare modelli di IA su dati personali disponibili al pubblico nell'ambito del GDPR, possiamo dedurre che un'azienda dovrebbe seguire diverse fasi:

- Primo passo: scegliere una base giuridica per l'addestramento di modelli di intelligenza artificiale utilizzando dati disponibili al pubblico. Che si tratti di consenso, contratto, interesse legittimo o obbligo legale, è necessario scegliere una base giuridica e implementare i suoi requisiti in base alle disposizioni dell'articolo 6.

- Fase due: informare gli interessati che i loro dati personali disponibili al pubblico sono stati trattati per addestrare modelli di intelligenza artificiale, ai sensi dell ›articolo 14.

- Terza fase: Addestrare i modelli di intelligenza artificiale su categorie speciali di dati personali (dati che rivelano l'origine razziale o etnica, le opinioni politiche, le convinzioni religiose o filosofiche, ecc.) in base ai requisiti dell'articolo 9, vale a dire solo i dati resi manifestamente pubblici dagli interessati o in cui l'interessato fornisce un consenso esplicito, e nessun'altra legge lo impedisce.

Alla luce di ciò, è degno di nota il fatto che l'uE abbia iniziato ad agire in modo specifico sull'addestramento dei modelli di IA.

Nel marzo del 2023, il Garante per la protezione dei dati personali ha pubblicato un provvedimento esecutivo nei confronti di OpenAI.

Tra le varie non conformità riscontrate in merito a ChatGPT, una critica fondamentale è stata quella secondo cui OpenAI non si sarebbe assicurato una base giuridica ai sensi dell'articolo 6 GDPR per trattare i dati personali per l'addestramento iniziale degli algoritmi.

Analogamente, nell'ottobre 2022, la CNIL francese ha emesso un'ingiunzione nei confronti di Clearview AI e ha multato l'azienda.

Tra le varie violazioni GDPR , le pratiche di web crawling di Clearview AI per l'addestramento del suo software di riconoscimento facciale sono state esplicitamente ritenute una violazione degli obblighi di base dell'articolo 6.

La legge UE sull'intelligenza artificiale

l'europa è ora all'avanguardia nella regolamentazione dell'IA dopo che il Parlamento ha approvato l'EU AI Act.

l'anno scorso ho parlato con l'avvocato della privacy Anokhy Desai, che all'epoca mi disse: "Tutti gli occhi sono puntati sulla legge dell'UE sull'IA, che è in lavorazione già da qualche anno. Si prevede che venga adottata all'inizio del prossimo anno, il che significa che entrerà in vigore alla fine del 2025 o all'inizio del 2026".

"Tutti gli occhi sono puntati sull'AI Act dell'UE". Anokhy Desai, avvocato specializzato in privacy | CIPP/US, CIPT, CIPM, CIPP/C, CIPP/E, FIP

Ora parzialmente in vigore, la legge delinea principalmente i requisiti di trasparenza per la GenAI e colloca la tecnologia in diversi livelli di rischio.

Desai aggiunge: "La stessa legge sull'IA adotta un approccio alla regolamentazione dell'IA basato sul rischio e una recente disposizione aggiunta alla legge sull'IA richiederebbe alle ›aziende che impiegano strumenti di IA generativa, come ChatGPT... di divulgare qualsiasi materiale protetto da copyright utilizzato per sviluppare i loro sistemi›".

Tuttavia, la legge sull'IA dell'UE non stabilisce quali informazioni possono essere utilizzate a fini formativi.

"Non si sa ancora se in futuro emendamenti, deroghe o regole delineeranno i tipi accettabili di dati disponibili al pubblico", afferma Desai, "Per la loro natura di dati pubblici, non c'è alcuna privacy retroattiva aggiunta a tali dati".

Leggi sulla privacy negli Stati Uniti

Negli Stati Uniti, alcuni Stati hanno adottato un approccio diverso nei confronti dei dati disponibili al pubblico, in modo del tutto opposto alle normative dell'UE.

Desai afferma: "Tra le leggi sulla privacy a livello statale entrate in vigore quest'anno, alcune includono disposizioni sull'IA, come le limitazioni del CPRA sulla conservazione dei dati, la condivisione dei dati e l'uso di informazioni personali sensibili con l'iA".

Tuttavia, le seguenti leggi statali hanno escluso i dati disponibili al pubblico dalla definizione di informazioni personali e, quindi, dall'applicazione e dall'ambito di applicazione di tali leggi:

- Legge sulla privacy dei consumatori della California (CCPA)

- Legge sulla protezione dei dati dei consumatori della Virginia (VCDPA)

- Legge sulla privacy del Colorado (CPA)

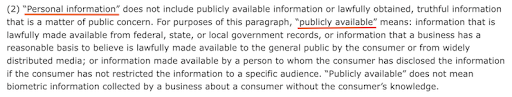

Prendiamo ad esempio il CCPA, come modificato dal CPRA, e leggiamo di seguito la definizione di "informazioni personali" e "disponibili al pubblico".

Di conseguenza, i dati disponibili al pubblico non rientrano nell'obbligo di notifica previsto dal CCPA né nei diritti dei consumatori alla cancellazione e all'opt-out dalle vendite e dalla condivisione.

"Sebbene nessuna di queste leggi menzioni l'uso di dati disponibili al pubblico per l'addestramento di modelli di IA", afferma Desai, "l'aumento esponenziale delle proposte di legge sull'IA indica la possibilità che una simile proposta venga presentata in futuro".

La mancanza di protezione dei dati pubblici può spiegare le recenti controversie su alcune aziende che si affidano a queste informazioni per addestrare modelli di intelligenza artificiale senza ottenere alcuna forma di consenso o altra base legale.

Ad esempio, nell'agosto 2023, Zoom è stato al centro di una controversia per le sue clausole sui termini di servizio relative all'utilizzo di informazioni personali per addestrare modelli di apprendimento automatico e di IA.

Allo stesso modo, anche OpenAI, Microsoft e Google devono affrontare azioni legali collettive negli Stati Uniti per le loro pratiche di scraping dei dati per l'addestramento dei modelli di IA.

Le piattaforme di social media possono usare i vostri dati per addestrare l'intelligenza artificiale?

Come abbiamo visto, i social media costituiscono un immenso bacino di dati - pubblici e non - e possono essere una risorsa per l'addestramento dei modelli di IA.

In generale, il fatto che i dati siano pubblici o privati dipende dalle impostazioni di privacy scelte dall'utente sulla piattaforma che sta utilizzando.

Le diverse piattaforme hanno scopi diversi per quanto riguarda ciò che può essere pubblico e approcci diversi per quanto riguarda il modo in cui gli altri possono utilizzare questi dati per addestrare i modelli di intelligenza artificiale.

Nella prossima sezione analizzeremo brevemente alcune delle piattaforme più diffuse.

Facebook e Instagram

Facebook e Instagram rientrano nell'ambito delle politiche di Meta relative ai dati pubblici.

In primo luogo, sì, entrambe le piattaforme utilizzano i dati pubblici della propria piattaforma per addestrare l'intelligenza artificiale di Meta, come ha recentemente riferito il presidente di Meta per gli affari globali, Nick Clegg.

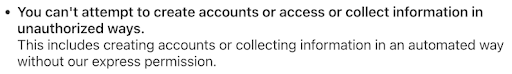

Per quanto riguarda la raccolta di dati pubblici da parte di soggetti esterni per l'addestramento di modelli di intelligenza artificiale, i termini di utilizzo di entrambe le piattaforme non la consentono senza il loro esplicito permesso, che possiamo solo supporre non concedano ai concorrenti.

Di seguito sono riportati i Termini di raccolta dati di Facebook.

Nella schermata seguente è possibile leggere i Termini di Instagram.

X/Twitter

Analogamente a Meta, i termini di X (ex Twitter) menzionano l'utilizzo di dati disponibili al pubblico per addestrare i modelli di apprendimento automatico delle aziende, come riportato da Techcrunch.

Inoltre, durante il lancio di xAI, Elon Musk ha dichiarato che utilizzerà i tweet pubblici per addestrare la sua nuova IA.

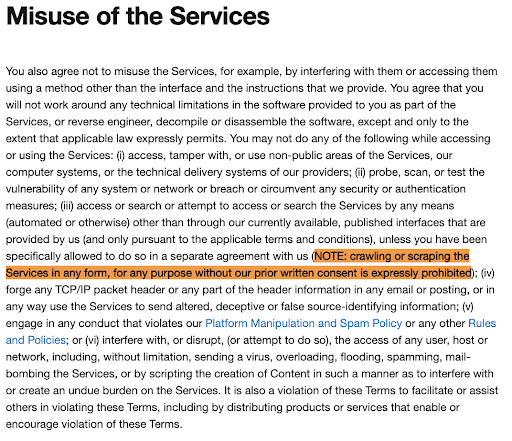

Per quanto riguarda l'accesso ai dati pubblici della piattaforma da parte di soggetti esterni, X ha specificamente aggiornato i suoi termini per vietare qualsiasi operazione di crawling o scraping per evitare l'addestramento dell'IA.

Questi termini sono visibili nella schermata sottostante.

Riassunto

l'addestramento di modelli di IA ha recentemente sollevato molte preoccupazioni per il suo immenso appetito di dati, compresi quelli personali.

Ma attingere alle informazioni disponibili pubblicamente è diventata la norma per gli sviluppatori di IA, perché le leggi sulla privacy sono più permissive riguardo a questo tipo di dati.

Tuttavia, gli eventi recenti indicano che le autorità di regolamentazione, il pubblico e le aziende di IA devono ancora costruire un terreno comune per sviluppare pratiche di formazione dell'IA più affidabili, tra cui:

- Sanzione di Clearview AI per la raccolta illegale di immagini pubbliche

- Le azioni legali collettive contro i principali attori dell'IA

- Risposta negativa del pubblico ai termini di servizio di Zoomnell'estate del 2023

Un primo passo verso questa fiducia potrebbe essere la ratifica e l'attuazione della legge europea sull'IA, che le istituzioni europee hanno finalizzato nel 2024.

In ogni caso, i dati personali devono rimanere protetti in base alle leggi vigenti e dobbiamo continuare a informarci sui dati pubblici e su come vengono utilizzati.